KIs werden nutzlos, wenn sie weiterhin von anderen KIs lernen

[ad_1]

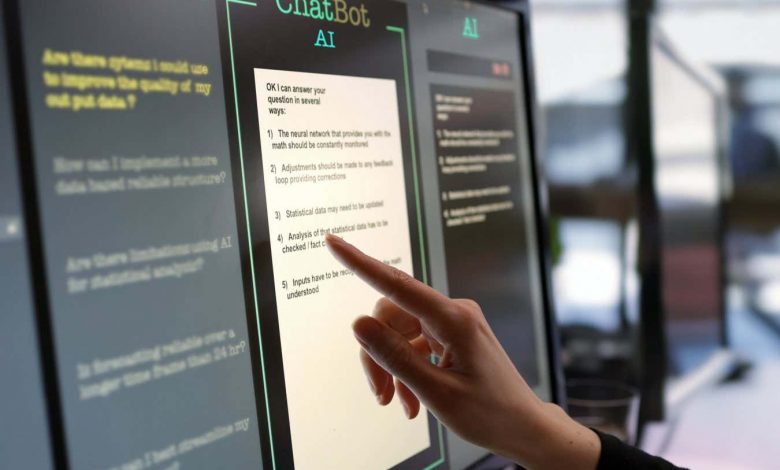

Chatbots nutzen statistische Modelle der menschlichen Sprache, um vorherzusagen, welche Wörter als nächstes kommen sollten

Laurence Dutton/Getty Images

Künstliche Intelligenzen, die mithilfe von Texten und Bildern anderer KIs trainiert werden, die ihrerseits auf KI-Ergebnisse trainiert wurden, könnten irgendwann funktional nutzlos werden.

KIs wie ChatGPT, bekannt als Large Language Models (LLMs), nutzen riesige Bestände an von Menschen geschriebenen Texten aus dem Internet, um ein statistisches Modell der menschlichen Sprache zu erstellen, sodass sie vorhersagen können, welche Wörter in einem Satz am wahrscheinlichsten als nächstes kommen . Seit sie verfügbar sind, ist das Internet mit KI-generierten Texten überschwemmt, aber die Auswirkungen, die dies auf zukünftige KIs haben wird, sind unklar.

Jetzt, Ilja Schumailow an der Universität Oxford und seine Kollegen haben herausgefunden, dass KI-Modelle, die mit den Ergebnissen anderer KIs trainiert wurden, stark voreingenommen, übermäßig einfach und von der Realität abgekoppelt werden – ein Problem, das sie als Modellkollaps bezeichnen.

Dieser Fehler tritt aufgrund der Art und Weise auf, wie KI-Modelle Text statistisch darstellen. Eine KI, die eine Phrase oder einen Satz oft sieht, wird diese Phrase wahrscheinlich in einer Ausgabe wiederholen und weniger wahrscheinlich etwas produzieren, was sie selten gesehen hat. Wenn neue Modelle dann auf Text von anderen KIs trainiert werden, sehen sie nur einen kleinen Bruchteil der möglichen Ausgaben der ursprünglichen KI. Es ist unwahrscheinlich, dass diese Teilmenge seltenere Ausgaben enthält, und daher wird die neue KI sie nicht in ihre eigenen möglichen Ausgaben einbeziehen.

Das Modell hat auch keine Möglichkeit, es zu sagen ob der von der KI generierte Text, den er unterteilt, der Realität entspricht, was zu noch mehr Fehlinformationen führen könnte als aktuelle Modelle.

Ein Mangel an ausreichend vielfältigen Trainingsdaten wird durch Mängel in den Modellen selbst und der Art und Weise, wie sie trainiert werden, verschärft, die die zugrunde liegenden Daten nicht immer perfekt darstellen. Shumailov und sein Team zeigten, dass dies bei einer Vielzahl unterschiedlicher KI-Modelle zum Modellkollaps führt. „Während sich dieser Prozess wiederholt, geraten wir letztendlich in einen Zustand des Wahnsinns, in dem es nur noch Fehler, Fehler und Fehler gibt und das Ausmaß der Fehler viel größer ist als alles andere“, sagt Shumailov.

Wie schnell dieser Prozess abläuft, hängt von der Menge der KI-generierten Inhalte in den Trainingsdaten einer KI und der Art des verwendeten Modells ab, aber alle Modelle, die KI-Daten ausgesetzt sind, scheinen irgendwann zusammenzubrechen.

Die einzige Möglichkeit, dies zu umgehen, bestünde darin, die von der KI generierten Ausgaben zu kennzeichnen und auszuschließen, sagt Shumailov. Dies ist jedoch nicht zuverlässig möglich, es sei denn, Sie verfügen über eine Schnittstelle, über die Menschen bekanntermaßen Text eingeben, wie etwa Google oder die ChatGPT-Schnittstelle von OpenAI – eine Dynamik, die die bereits erheblichen finanziellen und rechnerischen Vorteile großer Technologieunternehmen festigen könnte.

Einige der Fehler könnten gemildert werden, indem man KIs anweist, Trainingsdaten aus der Zeit vor der Flut von KI-Inhalten im Internet zu bevorzugen, heißt es Vinu Sadasivan an der University of Maryland.

Es sei auch möglich, dass Menschen keine KI-Inhalte ins Internet stellen, ohne sie vorher selbst zu bearbeiten, sagt er Florian Tramer an der Eidgenössischen Technischen Hochschule Zürich. „Selbst wenn das LLM selbst in gewisser Weise voreingenommen ist, könnte der menschliche Eingabe- und Filterprozess dies abmildern, sodass die Endergebnisse näher an der ursprünglichen menschlichen Voreingenommenheit liegen“, sagt er.

Themen:

[ad_2]

Source link